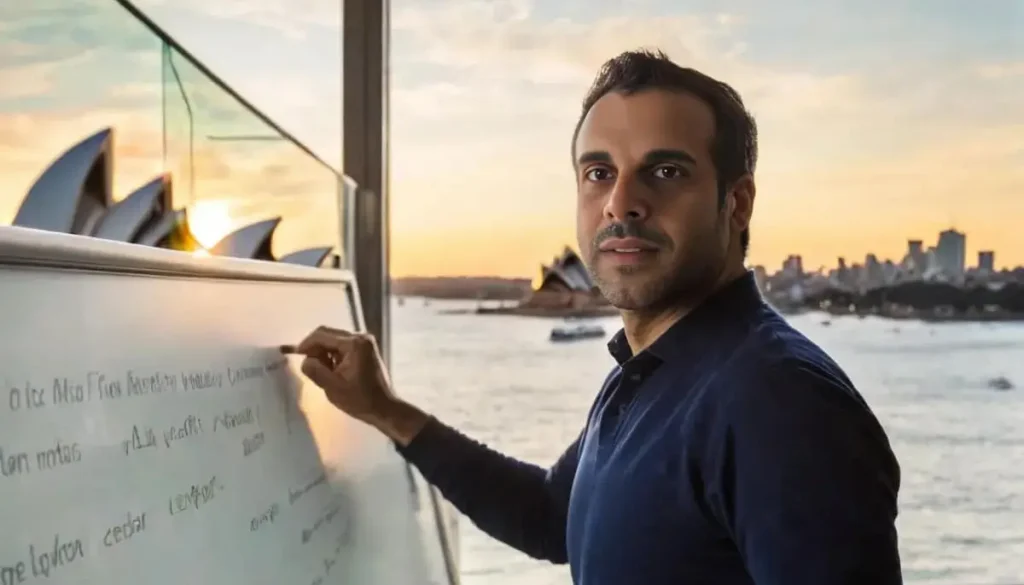

דף הבית » יובל אבידני עושה קצת סדר במודלי שפה גדולים

קצת סדר במודלים של שפה, או בהגה המקצועית: מודלי שפה גדולים: LLMs – Large Language Model.

אבל לפני הכל – הישארו מעודכנים! הצטרפו לרשימת התפוצה שלנו ולא תפספסו שום עדכון, חידוש או מידע על כלי חדש שיוצא…

מודלים סגורים שניתן לדבר איתם הם GPT, קלוד ai, ג׳ימיני (בארד לשעבר). נכנסים לאתר – יש ממשק. מתכתבים.

מודלים פתוחים שניתן לדבר איתם הם: Llama-2, Mixtral, Falcon, Wizard ועוד רבים רבים שמופיעים בחינם ב-HuggingFace, האתר שמרכז את כל כלי הAI החינמיים, שעבדו עליהם קשה מאוד. מתוך HuggingFace מורידים את המודלים, מתקינים תוכנה מגשרת כמו GPT4ALL או OogaBooga או LMStudio, בוחרים את המודל שהורדנו, ומתחילים להתכתב בממשק של התוכנה הזו.

חוקרים מאוניברסיטת MBZUAI ערכו מחקר שיכול לשנות את האופן שבו אנו מנהלים שיחות עם צ’אט גיפיטי (chat gpt). הם גילו עשרות טכניקות מפתיעות שמשפרות באופן דרמטי את איכות התשובות של מודלי שפה גדולים (LLMs), כמו למשל: דיבור חיובי ולא שלילי (מה כן לעשות ולא מה לא לעשות), או אף להזהיר את הבוט שהוא ייענש אם התשובות שלו לא יהיו טובות. כן כן – זה אמיתי. לקריאת המאמר לחצו פה.

26 strategies

בואו ללמוד איתנו בינה מלאכותית בקורס המקיף, העשיר והמבוקש בשוק. הצטרפו לאלפים הרבים שכבר עברו את הקורסים והסדנאות שלנו. פרטים והרשמה באתר.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

רוצים לקבל עדכונים על כל מה שחדש ומעניין בעולם ה-AI? הרשמו לניוזלטר שלנו!

תוצאות נוספות...