דף הבית » בינה מלחמתית – דיווח: צבא ארה”ב מתנסה בצ’טבוטים של בינה מלאכותית במשחקי מלחמה

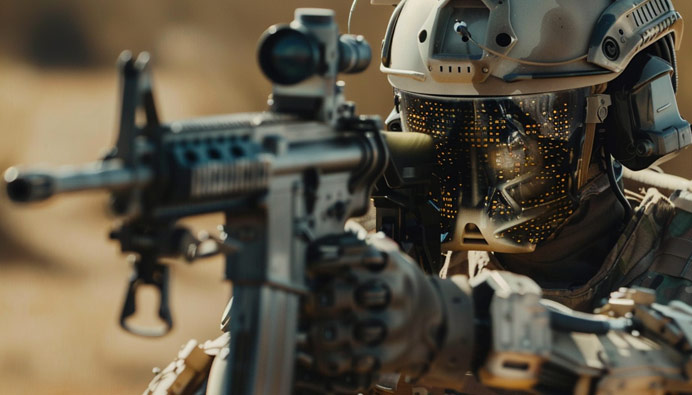

האם מעבדת המחקר של צבא ארה"ב עושה ניסויים בטכנולוגיות AI ג'נרטיביות במשחקי מלחמה? מסתמן שזהו צעד נוסף בניסיונות של הצבא להטמיע יכולות בינה מלאכותית מתקדמות בשדה הקרב ובתהליכי קבלת החלטות צבאיות.

אבל לפני הכל - הישארו מעודכנים! הצטרפו לרשימת התפוצה שלנו ולא תפספסו שום עדכון, חידוש או מידע על כלי חדש שיוצא...

ממליצים לכם להצטרף גם לקהילות ה-AI של LetsAI בוואטסאפ ובטלגרם. רוצים לשמוע על הקורסים וסדנאות ה-AI שלנו? לחצו פה.

על פי דיווח ב-New Scientist, חוקרים ממעבדת המחקר של צבא ארה"ב (ARL) עשו שימוש במודלי השפה המתקדמים GPT4 ו-GPT4-Vision של חברת OpenAI במשחק מלחמה ממוחשב. המשימה הייתה לשלב את המידע שסיפקו המודלים הללו על מצב כוחות הצבא, השטח והאויבים, על מנת לגבש תוכנית פעולה לכיבוש יעד אסטרטגי תוך השמדת כוחות האויב.

החוקרים שילבו את מודלי ה-GPT עם שני מודלים "מסורתיים" יותר של בינה מלאכותית כדי להשוות ביצועים. ממצאי הניסוי הראו שאמנם מודלי ה-GPT הציגו פתרונות טקטיים מגוונים ויצירתיים יותר, אך גם הובילו למספר רב יותר של "נפגעים" היפותטיים במהלך ביצוע המשימה.

מדובר בדוגמה נוספת לשילוב של טכנולוגיות בינה מלאכותית חדשניות בתרגילי צבא ומשחקי מלחמה, במטרה להעריך את הפוטנציאל שלהן לשפר תהליכי קבלת החלטות ותכנון מבצעים.

בשנים האחרונות, גופי צבא ובטחון שונים החלו לנסות מגוון רחב של יישומי בינה מלאכותית, החל מזיהוי מטרות וסיכולן ועד לסימולציות ומשחקי תרגול.

מאמץ מרכזי בתחום זה הוא פרויקט המכונה "מייבן" של משרד ההגנה האמריקני. במסגרתו ממונפים פיתוחים בבינה מלאכותית לצרכי ריגול, איתור מטרות, תכנון מבצעים ועוד. כך, למשל, יישומי בינה מלאכותית של הפרויקט עזרו לאתר משגרי רקטות בתימן, לצמצם מטרות לתקיפה בעיראק ובסוריה ולזהות כלי שיט עוינים.

עם זאת, השימוש ההולך וגובר של צבאות בטכנולוגיות בינה מלאכותית במערכות לחימה מעורר גם חששות וסוגיות אתיות רבות. השארת החלטות שעלולות לגרום לפגיעה באנשים בידי אלגוריתמים ממחישה את הסיכונים האפשריים הכרוכים בשילוב לא מבוקר של בינה מלאכותית בפעילות צבאית.

על פי האו"ם וגורמים רשמיים במדינות מערביות רבות, חשוב להגביל ולפקח על השימוש בבינה מלאכותית במערכות לחימה לתפקידים מוגדרים היטב, תוך הותרת החלטות מכריעות בידיים אנושיות. בנוסף, יש להקפיד להטמיע ערכים אתיים ולבנות מנגנוני בקרה בתוך המערכות עצמן כדי למנוע תקלות ותרחישי קיצון. האם בפועל כללים אלו מיושמים בשטח - המידע כמובן מסווג ותלוי את מי שואלים...

על אף החששות הללו, נראה כי השאיפה להשיג יתרון טכנולוגי צבאי באמצעות בינה מלאכותית תימשך ואף תגבר. הפנטגון, למשל, ביקש מיליארדי דולרים מהממשל האמריקאי כדי להמשיך ולפתח יכולות בינה מלאכותית לצרכים צבאיים. גם תפקיד של "מנהל דיגיטלי ו-AI" הוקם במשרד ההגנה כדי להוביל את ההטמעה של הטכנולוגיה בזרועות השונות.

כדאי להזכיר את הדיווח הנוסף המעניין שנחשפנו אליו עוד בשלהי 2023 בנוגע למאמציה של ארצות הברית להסדיר את נושא השימוש בבינה מלאכותית בנושאים צבאיים.

האתגר גם אז היה ברור. בזמן שטכנולוגיות AI מציעות יתרונות אסטרטגיים משמעותיים לכוחות הצבא המודרניים, הן גם מציבות דילמות אתיות וסיכונים בטיחותיים חדשים. הסדר העולמי החדש דורש התייחסות הוליסטית לשילובה של בינה מלאכותית בעולם הביטחון והפיקוח הבינלאומי עליה.

ואכן, ממשלת ארה"ב נוקטת צעדים נחושים להוביל את העולם בקידום נורמות ברורות לשימוש אחראי בבינה מלאכותית ובמערכות אוטונומיות בהקשר הצבאי. יוזמה מרכזית בכיוון זה היא "ההצהרה הפוליטית על שימוש צבאי אחראי בבינה מלאכותית ואוטונומיה" שהשיקה וושינגטון ב-16 בפברואר 23.

ההצהרה, שכבר אומצה על ידי 47 מדינות, מגדירה קווים מנחים לא מחייבים משפטית בנוגע לדרכי העבודה הנכונות לשילוב בינה מלאכותית בפעילות צבאית. בין היתר, היא קובעת שמערכות בינה מלאכותית צבאיות חייבות להיות שקופות, עם שימושים מוגדרים היטב, כפופות לבקרה וביקורת קפדניות ובעלות מנגנונים למניעת התנהגויות בלתי רצויות.

משמעות הדבר היא קידום תפיסה של פיקוח אנושי מלא על מערכות בינה מלאכותית בצבא ועל תהליכי קבלת ההחלטות המרכזיים. בכך, נשמר עקרון הגנה חיוני על זכויות האדם והמוסר המלחמתי ונמנע סיכון של המרת מערכות צבאיות לישויות "אוטונומיות" לחלוטין וחסרות אחריותיות.

מהלך זה של ארה"ב לא הפתיע כלל, שכן משרד ההגנה האמריקני הוביל זה עשור קידום של עקרונות אתיים בשילוב בינה מלאכותית ואוטונומיה בתחום הלחימה. כעת, וושינגטון מנסה להרחיב את ההשפעה לזירה הגלובלית בתקווה ליצור משטר בינלאומי מסודר להסדרת התחום.

עם זאת, המטרה אינה רק בניית גדרות אלא גם העצמת היכולות הצבאיות באמצעות חדשנות. אסטרטגיית הנתונים וקידום הבינה המלאכותית של משרד ההגנה מתריעה על הצורך "לנצל את היתרונות העצומים של בינה מלאכותית כדי להשאר קדימה בעימות על-איומי".

לפיכך, ארה"ב פועלת במקביל בשני מסלולים - גיבוש רגולציה גלובלית ופיתוח מואץ של יכולות בינה מלאכותית לצרכים ביטחוניים. השאיפה היא למנוע הידרדרות לדילמת האסיר בינלאומית ומרוץ חימוש לא רצוי, תוך שמירה על יתרון טכנו-צבאי אמריקאי בזירה התחרותית.

נראה כי גם מדינות אחרות החלו לפקוח עיניים לפוטנציאל ולסיכונים הטמונים בבינה המלאכותית הצבאית. סימן לכך הוא העובדה שכבר 47 מדינות אימצו את ההצהרה האמריקנית. קהילה בינלאומית זו תשמש בוודאי כבסיס ראשוני לגיבוש נורמות מחייבות ומסגרות אחריות בשלב הבא. יהיה מעניין.

אין ספק שבינה מלאכותית תמשיך להשפיע באופן מרחיק לכת על עולם הביטחון והצבא בשנים הקרובות. השאלה המרכזית שצריכה להיות במוקד הדיון הציבורי היא כיצד ניתן לנצל את הפוטנציאל הגלום בטכנולוגיה הזו תוך הגבלת הסיכונים וההשלכות השליליות.

בואו ללמוד איתנו בינה מלאכותית בקורס המקיף, העשיר והמבוקש בשוק. הצטרפו לאלפים הרבים שכבר עברו את הקורסים והסדנאות שלנו. פרטים והרשמה באתר.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

רוצים לקבל עדכונים על כל מה שחדש ומעניין בעולם ה-AI? הרשמו לניוזלטר שלנו!

תוצאות נוספות...