דף הבית » מהירות זה שם המשחק! הכירו את גרוק Groq – פלטפורמה מהירה במיוחד ל־LLMs

חברת הסטארט־אפ גרוק (Groq) מבקשת לחולל מהפכה של ממש בעולם מודלי השפה הגדולים (LLMs) בעזרת שבבים חדשניים פרי פיתוחה: שבבי LPU (ראשי תיבות של Language Processing Unit – יחידת עיבוד שפה). שבבים אלו נוצרו במיוחד לשיפור הביצועים של מערכות בינה מלאכותית גדולות ומורכבות ובעיקר על מודלים של שפה טבעית (Large Language Models). מערכות אלה נמצאות בליבת יישומים כמו צ’טבוטים ג’נרטיביים (דוגמת ChatGPT ,Claude ו־Gemini) וכלים ליצירת תוכן טקסטואלי.

החידוש המרכזי של שבבי LPU הוא בארכיטקטורת הזיכרון שלהם. אם שבבי GPU (Graphics Processing Unit), הנפוצים בשימוש כיום, מסתמכים על סוגי זיכרון המצריכים ריענון תכוף, שבבי ה־LPU של גרוק מבוססים על זיכרון סטטי (SRAM) שאינו מצריך ריענון ומאפשר גישה מהירה יותר למידע. יתרון נוסף לשבבים האלה הוא היכולת לקבוע מראש תהליכים יעילים לאיתור המידע הדרוש, דבר שמייעל את תהליכי העיבוד. תכונות ייחודיות אלה מקנות לשבבי ה־LPU יתרון מובהק על פני טכנולוגיות מסורתיות בתחום בכל הנוגע לביצועים.

במסגרת הטכנולוגיה המתקדמת גרוק גם פיתחה קומפיילר ייחודי שמתרגם אלגוריתמים של למידת מכונה לפורמט שיכול לרוץ ביעילות על שבבי ה־LPU. כבר כיום אפשר להתנסות בשבבים אלה באמצעות מודלים מתקדמים של קוד פתוח כמו Llama 2 או 3 של מטא ו־Mixtral 8x7B של חברת Mistral הצרפתית. איך זה נראה בפועל? בהשוואה ישירה שבבי ה־LPU של גרוק הראו יתרון ניכר בביצועים לעומת מודלים דומים הרצים על שבבי NVIDIA המסורתיים.

אבל לפני הכול – הישארו מעודכנים! הצטרפו לרשימת התפוצה שלנו ולא תפספסו שום עדכונים, חידושים או מידעים על כלים חדש שיוצאים.

ממליצים לכם להצטרף גם לקהילות ה־AI של LetsAI בוואטסאפ ובטלגרם. רוצים לשמוע על הקורסים וסדנאות ה־AI שלנו? לחצו פה.

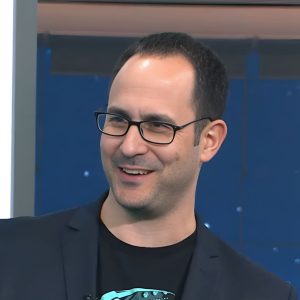

ג’ונתן רוס הוא המייסד והמנכ”ל של חברת גרוק. יש לו ניסיון עשיר בתחום הבינה המלאכותית, ובעבר היה חלק מהצוות שפיתח את שבבי TPU (Tensor Processing Unit) לעיבוד בינה מלאכותית בענן של חברת גוגל. חברת גרוק עצמה הוקמה בשנת 2016 כחלק ממגמת הסטארט־אפים שחרטו על דגלם את קידום תחום הבינה המלאכותית. השם ‘גרוק’ לקוח מרומן מדע בדיוני ומשמעותו ‘להבין משהו לעומק ובאמפתיה’ (כך מספר רוס בראיון ל־CNN) – רמז לחזונה של החברה לייצר שבבים שיאפשרו למערכות בינה מלאכותית להבין שפה בטבעיות ולעומק. תחת הנהגתו של רוס גרוק השכילה לפתח טכנולוגיה חדשנית בדמות שבבי LPU המשלבים יכולות חישוב גבוהות עם ארכיטקטורת זיכרון ייחודית. שילוב זה הוביל למהפכת המהירות שהחברה חוללה בתחום הבינה המלאכותית הגנרטיבית.

בעולם הבינה המלאכותית מתחולל שינוי דרמטי – עוד ועוד חברות משיקות מוצרים ושירותים ג’נרטיביים, ובליבם של רבים מהם עומדים מודלי חישוב שמצריכים קצב פעילות מהיר מאוד! הדבר נכון כפליים בעולם מודלי השפה הגדולים, שם האינטראקצייה עם משתמשים אנושיים הדוקה, ולמהירות התגובה של הכלי יש השפעה דרמטית על חווית המשתמש (לעיתים לא פחות מאיכות התשובה). החברה שמובילה את מהפכת המהירות היא גרוק. שבבי ה־LPU שפיתחה יכולים להריץ מודלי שפה גדולים שזמינים בקוד פתוח במהירות הגבוהה פי 10 ולעיתים אף פי 100 מכל טכנולוגיה אחרת המוכרת כיום בשוק.

שבבי LPU של גרוק מציעים יכולת עיבוד נתונים אדירה המבוססת על ארכיטקטורה חדשנית. חברת גרוק טוענת שהשבבים שלה שוברים שיאי מהירות כמעט בכל שבוע ומסוגלים לעבד עד 500 טוקנים (tokens) בשנייה – במהירות כזאת אפשר לייצר טקסט ארוך כרומן בתוך כ־100 שניות בלבד. באתר של החברה, שבו תוכלו להתנסות בעצמכם במודלים, אפשר לראות גם באיזו מהירות גרוק מייצר תוכן – וכן, זה מדהים כמו שזה נראה!

בסרטון שלפניכם אפשר לראות השוואה בזמן אמת בין הרצה של מודל Llama3 70B החדש של מטא בפלטפורמה של גרוק ובין אותו פרומפט בדיוק ב־Meta AI. גרוק משלים את העבודה מהר יותר באופן מובהק ומצליח לייצר 262 טוקנים בשנייה אחת בלבד.

בבדיקה שאנחנו עשינו, ביקשנו מגרוק לכתוב (בעזרת מודל Llama3 8B) סיפור באורך של 2000 טוקנים על יציאת בני ישראל ממצרים אבל בחלל. גרוק הצטיין וכתב את הסיפור כהרף עין בתוך 2 שניות בלבד (קצב של 807 טוקנים לשנייה). לא מאמינים? נסו בעצמכם!

אחר כך זרקתי את כל הסיפור הארוך הזה למידג’רני כפרומפט אחד. אם תהיתם איך נראית יציאת מצרים בחלל, אז מתברר שככה:

יציאת מצרים בחלל – פרומפט: לאמה3 בגרוק. תמונה: מידג’רני. עכשיו דמיינו שהייתם קוראים את המשפט הזה לפני שנתיים־שלוש; יש מצב שזה היה נראה לכם כמו סינית 🙂

.

חשוב להבין – זה הרבה יותר מגימיק! יתרון המהירות הזה אינו שולי כלל, והוא גיים צ’יינג’ר של ממש. לפי ג’ונתן רוס המהירות קריטית לשמירה על מעורבות המשתמש: שיפור של 100 מילי־שניות במהירות התגובה באתר אינטרנט מביא לעלייה של 8% במעורבות המשתמשים. בסביבת המובייל – שם המשתמשים חסרי הסבלנות אף יותר – עלייה של 100 מילי־שניות מגדילה את המעורבות בלא פחות מ־34%.

הסיבה המרכזית ליתרון המהירות האדיר של שבבי LPU נעוצה בארכיטקטורת הזיכרון הייחודית שלהם. שבבי GPU (Graphic Processing Unit) הנפוצים כיום סובלים ממגבלת זיכרון פנימי קטן, כך שהם נאלצים לקרוא ולכתוב בתכיפות מזיכרון חיצוני. תהליך זה דומה לקו ייצור שכולל בתוכו מסלולים רבים וגורם לעיכובים וצווארי בקבוק משמעותיים. לעומת זאת, בשבבי LPU שעליהם מבוסס גרוק, כמות הזיכרון הפנימי גדולה בהרבה, וארכיטקטורת הזיכרון מבוססת על SRAM – זיכרון סטטי שאינו מצריך ריענון תדיר. התכנון הייחודי הזה מאפשר לשבב לגשת למידע במהירות גבוהה ביותר בלי צורך בהעברה מתמדת של נתונים.

נוסף על כך, שבבי ה־LPU של גרוק יכולים לקבוע מראש תהליכים יעילים לאיתור המידע הדרוש, וזה מייעל עוד יותר את תהליכי העיבוד. תכונות חדשניות אלה מבטיחות זרימת נתונים חלקה ומהירה באופן דרמטי, וזרימת נתונים זאת מעמידה את גרוק בעמדת יתרון ברורה על פני המתחרים. מהפכת השבבים של גרוק צפויה לשפר מאוד את חוויית המשתמש בכלי AI שונים. המהירות הגבוהה תאפשר אינטראקצייה טבעית ורהוטה יותר עם מערכות מבוססות שפה כמו צ’טבוטים וסוכני AI ללא השהיות וחוסר רציפות.

מוזמנים לצפות בריאיון של ג’ונתן רוס, מנכ”ל ומייסד Groq, ב־CNN. בריאיון הוא מרחיב על הכלי ואף מדגים בשידור חי את היכולות המרשימות שלו (מה שמותיר את המראיינת פעורת פה).

בריאיון המצולם רוס ממחיש בדוגמה ברורה עד כמה המהירות קריטית; הוא מסביר למראיינת שאם הוא היה מדבר בקצב איטי, זה היה משעמם ומייאש את הצופים, וכך גם בשימוש במודלי שפה. הדינמיות והטבעיות של השבבים החדשים יוצרות חוויה שוטפת הדומה לשיחה בין בן אדם.

חשוב להבהיר – גרוק עצמה אינה יוצרת LLMs חדשים. במקום זאת היא מרכזת על הפלטפורמות שלה מודלים קיימים, כולל מודלי קוד פתוח, ומאפשרת להריץ אותם במהירות עצומה באמצעות שבבי ה־LPU המתקדמים שלה. היתרון הגדול של גרוק הוא ביכולת המהירה לבצע חיזוי (inference) על בסיס מודלים קיימים. הארכיטקטורה הייחודית של השבבים מאפשרת זרימת נתונים מהירה ויעילה ללא חסמים טכנולוגיים המגבילים מערכות מסורתיות.

טכנולוגיית גרוק מיועדת להכניס בטבעיות את הבינה המלאכותית לשימושים היום־יומיים שלנו. חברות עסקיות יוכלו להשתמש בשבבי ה־LPU כדי לבנות יישומים המבוססים על בינה מלאכותית ומאפשרים חווית משתמש רהוטה וזורמת. דוגמאות ליישומים אפשריים כאלה הן כמעט אין־סופיות וכוללות כלי AI לשירות לקוחות, כלי כתיבה וסיכום חכמים ומהירים, ממשקים קוליים טבעיים ללא השהייה, תרגום שפות בזמן אמת, עריכת תוכן וידאו ממוחשבת ומהירה במיוחד ועוד. היכולת לבצע חיזוי מהיר עוזרת לפתח יישומי בינה מלאכותית בתחבורה אוטונומית, ברפואה ובעוד תחומים. במקום לקבל תשובות איטיות ומייגעות המשתמשים יזכו לחוויה רצופה ודינמית המדמה אינטראקצייה עם בן אדם. כך מסירה הטכנולוגיה את החסמים הטכנולוגיים שהפריעו בעבר לשימוש נוח בבינה מלאכותית, ומביאה בשורה של ממש.

לפי התחזיות של גרוק ושל המנכ”ל רוס 2024 תהיה שנת המפנה שהבינה המלאכותית תיעשה טבעית ו’אמיתית’ לחלוטין למשתמשים. לטענתו השבבים המהפכניים של החברה צפויים לשחק תפקיד משמעותי בהתפתחות הזאת. בזכות יכולת העיבוד המהירה והארכיטקטורה הנוחה לניצול של מודלים קיימים גרוק עשויה להוביל לאימוץ נרחב של טכנולוגיות בינה מלאכותית גנרטיבית בתעשיות השונות. במקום להסתמך על טכנולוגיות איטיות ולא נוחות חברות יוכלו לשלב ביישומים שלהן יכולות בינה מלאכותית המשוכללות במהירות אמיתית. ההתקדמות הטכנולוגית הזאת עשויה לקדם את החדשנות ואת הפריון במגוון תחומים מלבד השיפור הצפוי בחוויית המשתמש. גרוק מתכוונת לפרוץ את הגבולות ולקדם את הבינה המלאכותית משחקן משני לשחקן מרכזי בחיינו. נראה שגם השוק מתחיל להתאהב בכלי החדש. בסרטון שפרסמה החברה בתחילת מרץ 2024, היא מתפארת בהיקף האימוץ של הטכנולוגיה שלה: בטווח זמן של שבועיים בלבד כחצי מיליון משתמשים ביקרו בצ’אט של גרוק וכ־15,000 מפתחים עושים שימוש בענן של גרוק. ולא נראה שזה הולך לעצור.

באתר אפשר להריץ מספר מודלים בקוד פתוח:

גרוק הדגימה ביצועים של מודלי שפה טבעית גדולים (LLM) שהיו מהירים פי 15 מהמהירות של הספקיות המובילות מבוססות הענן, כך פורסם ב־ArtificialAnalysis.ai.

כאמור, בתוך Groq תוכלו להשתמש גם במודל החדש של מטא, Llama3. הינה כמה דברים שכדאי לדעת עליו. Llama 3 היא המהדורה החדשה והמשופרת של מודל השפה הגדול והחופשי לשימוש (LLM) שפיתחה חברת מטא (לשעבר פייסבוק). מדובר במודל הפתוח והחזק ביותר שהשיקה מטא עד כה הכולל גרסאות בנות 8 מיליארד ו־70 מיליארד פרמטרים. Llama 3 מציגה ביצועים מובילים בתעשייה במגוון רחב של משימות ויישומים כולל שיפורים מובהקים ביכולות ההיסק, התכנות והחשיבה הלוגית. מודלי Llama 3 מציגים ביצועים לא רעים בכלל – הרבה יותר טובים מ־GPT3.5 ודומים ברמתם ל־GPT4 (אם כי לא ברמה של Claude3). מלבד גרוק מודלי Llama 3 זמינים כעת לשימוש חופשי בפלטפורמות מובילות כמו AWS, Databricks, Hugging Face וכן בכלי העזר החדשים של מטא (Meta AI).

איפה עוד אפשר להשתמש ב

הטכנולוגיה החדשנית של שבבי ה־LPU של גרוק מבשרת על בואו של עידן חדש בתחום הבינה המלאכותית הגנרטיבית (GenAI). בעולם המתקדם הזה יש צורך הולך וגובר ביכולות עיבוד חזקות ובביצועי חישוב אדירים, ושבבי ה־LPU מספקים את המענה לאתגר זה. כשמודלים גדולים וחזקים יותר המכילים כמות פרמטרים גדולה יותר וקונטקסט גדול יותר, חוברים למהירות העל של השבבים של גרוק, נוצר עולם חדש של הזדמנויות. זאת זריקת בוסט לתעשייה שכבר נמצאת במרוץ חימוש אימתני. בשחרור הפוטנציאל העצום הטמון בטכנולוגיה זו, גבולות היכולת של יישומי GenAI ישתנו לחלוטין, והם יהיו חלק טבעי ואינטגרלי מחיי היום־יום שלנו.

בואו ללמוד איתנו בינה מלאכותית בקורס המקיף, העשיר והמבוקש בשוק. הצטרפו לאלפים הרבים שכבר עברו את הקורסים והסדנאות שלנו. פרטים והרשמה באתר.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

רוצים לקבל עדכונים על כל מה שחדש ומעניין בעולם ה-AI? הרשמו לניוזלטר שלנו!

תוצאות נוספות...