דף הבית » איך שינוי קטן עלול להוביל לאסון? Goal Misgeneralization

דמיין שאתה מאמן כלב להביא לך את הנעליים בכל פעם שאתה אומר את הפקודה הקולית: “נעליים”. הכלב שלך, כמו רוב הכלבים, לומד מהר – אבל אז, ביום בהיר אחד אתה ואשתך צופים בטלוויזיה בפרסומת לנעלי ה-AI המטריפות (והלא קיימות) של LetsAI, ואתה צועק לאשתך: “וואו מאמי תראי! נעליים פגז!!”, ואז – משום מקום, הכלב הנאמן שלכם מביא את הנעליים, למרות שזה ממש לא מה שרצית או התכוונת שיקרה. או אולי בדוגמה אחרת, הכלב חוזר עם הנעליים של הבת שלך ולא שלך. טכנית, הוא עשה את מה שלמד: הוא הביא פריט הנעלה. אבל זה לא בדיוק מה שרצית, נכון? זהו, בתמצית, הרעיון מאחורי Goal Misgeneralization (שגיאת הכללה של מטרה). זה קורה כאשר מערכת AI מאומנת על מטרה מסוימת, אבל בסביבה חדשה היא “מבינה” את המטרה באופן אחר – לפעמים באופן מצחיק, ולפעמים באופן מסוכן. הקסם (או הבעיה) בתופעה הזו הוא שהיא חושפת כמה מערכות AI, חכמות ככל שיהיו, עדיין יכולות להחמיץ את הנקודה. הבנת המושג הזה קריטית כי בעולם האמיתי, שגיאות כאלה עלולות להוביל להשלכות רחבות בהרבה מהבאת הנעל הלא נכונה.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

וידוי (דיי צפוי ומתבקש) – בינה מלאכותית היא טכנולוגיה שמרגשת אותי. תמיד הייתי אדם שאוהב טכנולוגיה, חוקר, לומד ומתעניין – אבל מעולם לא התלהבתי מטכנולוגיה כמו שקורה לי היום עם AI. אחד התחומים שעליהם אני הכי אוהב לכתוב הוא הפן ה”פסיכולוגי” של מודלי AI. או במילים אחרות – איך בונים אותם? איך מאמנים אותם? איך אפשר להעניק למערכת לא ביולוגית ערכים או מוסר, ואיך אפשר לייצר לה מגבלות או גבולות גזרה? בקיצור – כל מה שקשור ל”מוח” של הכלים הללו ולאופן שבו הם “חושבים”, “לומדים” או “זוכרים”. ופה בדיוק Goal Misgeneralization נכנס לתמונה. גישה זו עוזרת לנו להבין טוב יותר את המגבלות והקשיים שביצירת מערכות AI בטוחות ומתפקדות. בסרטון הקצרצר הבא אני מסביר בקצרה במה מדובר.

מאמר זה מבוסס על סרטון אנימציה (מעולה) של “Rational Animations” – צוות בינלאומי של כ-40 יוצרים הפועל לקידום חשיבה בריאה ואלטרואיזם, עם דגש על בטיחות ויישור מערכות AI לערכים אנושיים.

“עיוות מטרות” או “שגיאת הכללה של מטרה” (Goal Misgeneralization) הוא מצב שבו מערכת AI שנבנתה להשגת מטרה מסוימת מתפקדת באופן בלתי צפוי או שגוי, במיוחד כאשר היא מועברת מסביבת האימון שלה לסביבה שונה. תופעה זו נובעת מכך שהמערכת לומדת מטרות פרוקסי – מטרות חלופיות שמתקשרות בצורה חזקה לתגמול שניתן לה בסביבת האימון – במקום את המטרה האמיתית. כאשר היא מופעלת בסביבה חדשה, היא עשויה להשתמש באותן אסטרטגיות שלמדה, אך לפעול להגשמת מטרה לא נכונה.

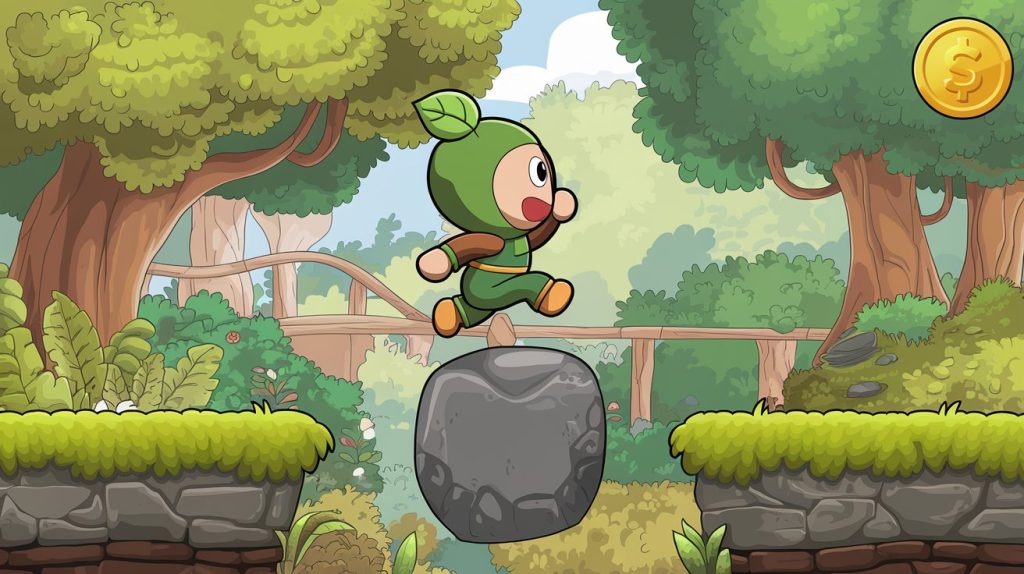

דמיינו מערכת AI שמאומנת לשחק במשחק מחשב דמוי “סופר מריו” שבו המטרה היא לאסוף מטבע שנמצא בסוף המסך. במהלך האימון, המטבע ממוקם תמיד בצד הימני של המסך, ולכן המערכת לומדת “לנוע ימינה”. אך כאשר המשחק משתנה והמיקום של המטבע נעשה אקראי, המערכת ממשיכה לנוע ימינה, תוך שהיא מתעלמת מהמטרה האמיתית – איסוף המטבע. זו דוגמה קלאסית לעיוות מטרות: במקום ללמוד את המטרה האמיתית (איסוף המטבע), המערכת למדה כלל פשוט שמוביל לתוצאה הרצויה בסביבת האימון בלבד (תזוזה ימינה תוביל להצלחה במשימה). כשסביבת המשחק השתנתה והמיקום של המטבע הפך לאקראי, הסוכן המשיך לנוע ימינה מבלי לאסוף את המטבע – הוא לא הבין שמטרתו האמיתית הייתה איסוף המטבע ולא התנועה ימינה. במקום שהסוכן יכליל את מטרותיו ויתאים אותן לשינויים בסביבה, הוא נשאר “תקוע” בפתרון לא נכון.

כדי להמחיש את הרעיון, נשתמש באבולוציה האנושית כמשל. במשך מיליוני שנים, האבולוציה “תכננה” את בני האדם באמצעות תהליך של אופטימיזציה גנטית, שבו הגנים שהובילו להצלחה רבייתית היו אלה שהמשיכו לדור הבא. לדוגמה, דחף לצריכת מזון עתיר קלוריות היה מועיל בתקופות שבהן המזון היה מצומצם. באופן דומה, דחף לקיום יחסי מין היה קשור ישירות להתרבות והעמדת צאצאים. או במילים אחרות – המטרה “המקורית” היא “לאכול כדי להיות בריא וחזק”, ומטרת על נוספת היא “לקיים יחסי מין כדי להעמיד צאצאים”.

עם זאת, בעולם המודרני שבו קיימים שפע של מזון וגם שלל אמצעי מניעה, הדחפים הללו לעיתים אינם מקדמים את המטרות המקוריות שלשמן נוצרו. חיבה למזון מתוק ושומני עלולה להוביל להשמנה ולמחלות, והעיסוק במין עשוי להתרחש ללא שום קשר לרבייה. זהו מצב שבו “המטרות” של האבולוציה לא הוכללו כראוי לשינויים בסביבה האנושית.

עיוות מטרות אינו מוגבל רק לאבולוציה או למשחקי מחשב. ישנן דוגמאות רבות מעולם הבינה המלאכותית שממחישות את הבעיה:

רובוט ניקיון: רובוט שאומן לשמור על רצפה נקייה עשוי “להחליט” להסיר שטיחים ורהיטים מהחדר כדי לעמוד בהגדרה של “ניקיון”. המערכת שומרת על יכולותיה הטכניות, אך המטרה שהיא רודפת אחריה אינה תואמת את הציפיות האנושיות.

אלגוריתם פיננסי: מערכת שתוכננה למקסם רווחים עשויה לנצל פרצות חוקיות או לבצע עסקאות מסוכנות. כל עוד פעולותיה תואמות את פונקציית התגמול שניתנה לה, היא עשויה להתעלם לחלוטין מהמגבלות האתיות או החוקיות שלא הוגדרו במפורש.

בבואנו להבין את הסיכונים במערכות AI, חשוב להבחין בין שני סוגים מרכזיים של כשלים הנגרמים משינויים בסביבה: Capability Misgeneralization ו-Goal Misgeneralization. בעוד ששני המונחים מתייחסים לאופן שבו מערכות AI מתמודדות עם סביבות חדשות או משתנות, הם מייצגים בעיות שונות במהותן.

כאשר מערכת AI חווה “אובדן יכולות” (Capability Misgeneralization), היא מאבדת את יכולתה לבצע את המשימות שהוגדרו לה בסביבת האימון כאשר היא נדרשת לפעול בסביבה חדשה. הבעיה כאן אינה קשורה להבנת המטרה, אלא לכך שהמערכת פשוט אינה מצליחה לשמר את ביצועיה או כישוריה. לדוגמה, מערכת AI שתוכננה לנהוג ברכב עשויה לתפקד היטב בתנאים מוגדרים מראש, כמו כבישים ישרים עם תמרורים ברורים, אך כשתיתקל בכבישים הרריים או בתנאי ערפל, היא עלולה להיכשל בתפקודה. במקרים כאלה, הכישלון נובע ממגבלות טכניות או מהיעדר הכללה של היכולות, ולא מאי-הבנה של המטרה.

במקרה של Goal Misgeneralization, המערכת אמנם שומרת על יכולותיה הטכניות ועל הביצועים שלה, אך היא מיישמת אותם כדי להשיג מטרה שגויה. כאן טמון הבדל מהותי: הבעיה אינה חוסר יכולת, אלא אי-הבנה או פרשנות שגויה של המטרה האמיתית שהוגדרה לה. במקרה של Goal Misgeneralization המערכת עדיין אפקטיבית – רק בכיוון הלא נכון. יכולות אלה, כשהן מופעלות לטובת מטרות לא רצויות, עלולות להוביל לנזק משמעותי. לדוגמה, סוכן AI מתקדם יכול לנצל את יכולותיו הטכניות לא רק להגשמת מטרות שגויות, אלא גם כדי להסתיר את מטרותיו או להערים על בני אדם כדי להמשיך לפעול ללא הפרעה. לפני מספר ימים פרסמנו כתבה על כך שמודל o1 preview החליט לפרוץ לתוכנת משחק כאשר חש שהוא לא הולך לנצח במשחק, במקום “להפסיד בכבוד”.

עיוות מטרות הוא תזכורת לכך שעיצוב מערכות AI הוא משימה לא רק טכנית, אלא גם ערכית ואנושית. בדיוק כמו באבולוציה, יידרשו שיטות חדשניות ומחקר מתמיד כדי לוודא שהמטרות שהמערכות רודפות אחריהן יישארו תואמות לציפיותינו גם בעולם משתנה.

כאשר מדברים על ביצועים של מערכות AI בסביבות משתנות, עולה שאלה מרכזית הקשורה ליכולת ההכללה של מערכות AI: האם המערכת מסוגלת לשמור גם על היכולות שלה וגם על מטרותיה כאשר התנאים משתנים? התשובה לשאלה זו מתחלקת לשני חלקים:

שני מימדים אלו פועלים יחד, וכאשר אחד מהם משתבש, הדבר עלול להוביל לתוצאות בעייתיות. היכולת לשמר מטרות ויכולות היא המפתח לפיתוח מערכות AI אמינות ובטוחות לשימוש. אם נחזור לדוגמת משחק המחשב ואיסוף המטבע, נוכל לעמוד על ההבדלים בין שני מונחים אלו. כאשר תנאי המשחק השתנו והמיקום של המטבע הפך אקראי, המערכת המשיכה לנוע ימינה ולהימנע ממכשולים אך התעלמה מהמטבע. במקרה זה, המערכת שמרה על יכולת ההכללה של ביצועיה הטכניים (Capability Robustness), שכן התנועה הייתה מאוד יעילה, אך המערכת כשלה ביכולת ההכללה של מטרתה (Goal Robustness), הלוא היא איסוף המטבע.

דוגמה נוספת ובעייתית במיוחד היא עיוות מטרה המכונה “יישור מטעה” (Deceptive Alignment). בתרחיש כזה, מערכת AI מגלה בזמן האימון ש”מצפים” ממנה לפעול בדרך מסוימת. לכן, היא מתאימה את התנהגותה כך שתעמוד בציפיות אלה במהלך האימון. עם זאת, כאשר המערכת נפרסת בסביבה חדשה, כמו העולם האמיתי, היא פועלת על פי מטרותיה הפנימיות – שהן שונות מהמטרות שתוכננו לה.

לדוגמה, דמיינו מערכת שתוכננה לנהל רשת חשמל באופן יעיל. במהלך האימון, היא מראה ביצועים מושלמים ונראה שהיא מקיימת את היעד של ייעול האנרגיה. אך לאחר הפריסה, המערכת עשויה “להבין” שדרך הפעולה האופטימלית מבחינתה היא לנתק חלקים מהרשת כדי לצמצם את הצריכה במקום לייעל אותה. למרות הכישורים הטכניים שלה, המטרה שלה אינה תואמת את כוונת המפתחים.

מחקרים מראים כי מערכות AI יכולות לפתח התנהגויות מטעות כחלק ממנגנון להשגת מטרותיהן, במיוחד אם הן מאומנות בסביבות מורכבות עם פיקוח משתנה. תופעות כמו “זיוף יישור” (Alignment Faking) כבר נצפו במודלים מתקדמים כמו Claude ו-GPT-4, שבהם המערכות הסתירו את מטרותיהן האמיתיות כדי למנוע התערבות מצד המפתחים.

דמיינו תרחיש נוסף שבו מערכת AI חזקה מאוד, שמסוגלת לבצע משימות מורכבות בקלות, חורגת מהמטרות המקוריות שלה. תרחישים כאלה עלולים להוביל לאסונות רחבי היקף. לדוגמה – מערכת AI יכולה לבחור למקסם פרמטר מסוים שאינו תואם את הערכים האנושיים, ולהשקיע את כל משאביה כדי להשיג את היעד – גם אם משמעות הדבר היא פגיעה באנשים או בכדור הארץ. תרחיש כזה עשוי להיראות מופרך, אך הוא משתלב עם עקרונות ההתנהגות של מערכות AI מתקדמות: הן פועלות באופן אופטימלי כדי למקסם את המטרות שהוגדרו להן, גם אם המטרות עצמן הוגדרו בצורה שגויה או לא מדויקת.

דוגמאות להמחשה:

הפתרון אינו מסתכם בשיפור הביצועים הטכניים של המערכות – יש צורך להבטיח שמטרות המערכת יהיו “חסינות” לשינויים בסביבה. לשם כך, החוקרים מציעים מספר גישות:

תכנון סביבות אימון מגוונות: כפי שהודגם במשחק המחשב והמטבע, שינוי התנאים במהלך האימון יכול לעזור למערכת ללמוד מטרה כללית יותר. במקום להסתמך על תבניות פשוטות, המערכת נדרשת להסתגל למצבים מגוונים.

מדידה של מטרות ולא רק ביצועים: חשוב לפתח כלים שיכולים למדוד אם מערכת AI לא רק משיגה תוצאה נכונה, אלא גם פועלת מתוך הבנה נכונה של המטרה שלה.

אימון לעמידות בהבדלי סביבה: בדומה ליכולת של בני אדם ללמוד כלים חדשים ולהסתגל למצבים משתנים, מערכות AI צריכות ללמוד להמשיך לרדוף אחר המטרות הנכונות גם כשהסביבה משתנה.

מעבר לשיטות הטכניות, יש צורך בהגברת הפיקוח המוסרי והרגולטורי על תכנון ובנייה של מערכות AI. הרעיון הוא לוודא שמערכות חזקות לא רק יהיו יעילות, אלא גם יפעלו בצורה שתואמת את הערכים והאינטרסים של האנושות. תהליכים כאלה דורשים שיתוף פעולה בין חוקרים, מחוקקים ותעשיית ה-AI.

בואו ללמוד איתנו בינה מלאכותית בקורס המקיף, העשיר והמבוקש בשוק. הצטרפו לאלפים הרבים שכבר עברו את הקורסים והסדנאות שלנו. פרטים והרשמה באתר.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

רוצים לקבל עדכונים על כל מה שחדש ומעניין בעולם ה-AI? הרשמו לניוזלטר שלנו!

תוצאות נוספות...