דף הבית » ניהול סיכונים עם כלים של בינה מלאכותית בעבודה

הדיון על בינה מלאכותית במקום העבודה כבר מזמן חרג משיחות על פרודוקטיביות או קיצורי דרך. ככל שהכלים החכמים נכנסים לעומק שגרת העבודה, כך גוברת גם הדילמה: איך משתמשים ביכולות המרשימות מבלי להעמיד את הארגון בסיכון? המאמר שלפניכם מציע לא רק אבחנה מדויקת של הסיכונים, אלא גם מתווה ברור לפעולה אחראית. הוא לא מיועד רק לאנשי אבטחת מידע, אלא לכל אחד מאיתנו – העובד, המנהל, או היועץ – שמבקשים לעשות שימוש נבון בכלי AI מבלי לשלם על כך מחיר כבד.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

שימוש בכלי בינה מלאכותית במקום העבודה פותח דלת להזדמנויות רבות – אך גם מציב שורת אתגרים מהותיים. בין אם מדובר בזליגת מידע רגיש, אי-הבנה של הגדרות פרטיות או שימוש שגוי במידע פנים, הסיכונים אינם תאורטיים. הם מוחשיים, יומיומיים ולעיתים בלתי הפיכים. כדי להתמודד איתם נדרשת לא רק מודעות, אלא גם אחריות אישית ומסגרת ברורה של כללים פנים-ארגוניים.

בעוד שהפוטנציאל של AI לשפר תהליכים, לקצר זמנים ולהגביר את הפרודוקטיביות הוא אדיר ובעל אימפקט אמיתי, חשוב להבין כי "כל הטוב הזה מגיע עם לא מעט סיכונים". התעלמות מהם עלולה להוביל לנזקים משמעותיים.

יש ספק - אין ספק! אם אתם לא בטוחים שהמידע שאתם מעלים למערכת AI מוגן, אל תעלו אותו!

הדגש המרכזי והנקודה החשובה ביותר היא אחריות המשתמש. לפני שאתם מעלים קובץ כלשהו או מכניסים מידע רגיש למערכת AI, חובה עליכם לפנות לגורמים המוסמכים בארגון שלכם. אל תסתמכו על הבטחות של גורם חיצוני, אלא ודאו מהי המדיניות הפנימית. פנו למחלקת אבטחת המידע (סייבר), למחלקת ה-IT או להנהלה, ובררו באופן מפורש מה מותר ומה אסור.

ככלל אצבע, יש להימנע לחלוטין מהעלאת מידע אישי, רפואי, פיננסי, ביטחוני או כל מידע פנימי וסודי אחר, אלא אם קיבלתם אישור מפורש לכך. חשוב להבין שהעובדה שלארגון יש רישיון לכלי AI מסוים (כמו Microsoft Copilot או Gemini של גוגל) אינה בהכרח אומרת שכל שימוש הוא מותר. לכל ארגון יש תשתית, הגדרות ורמות אבטחה שונות, ולכן המדיניות יכולה להשתנות באופן דרמטי בין חברות שונות. במקרה של ספק, הכלל הוא פשוט: "יש ספק - אין ספק". אם אינכם בטוחים, אל תעלו את המידע.

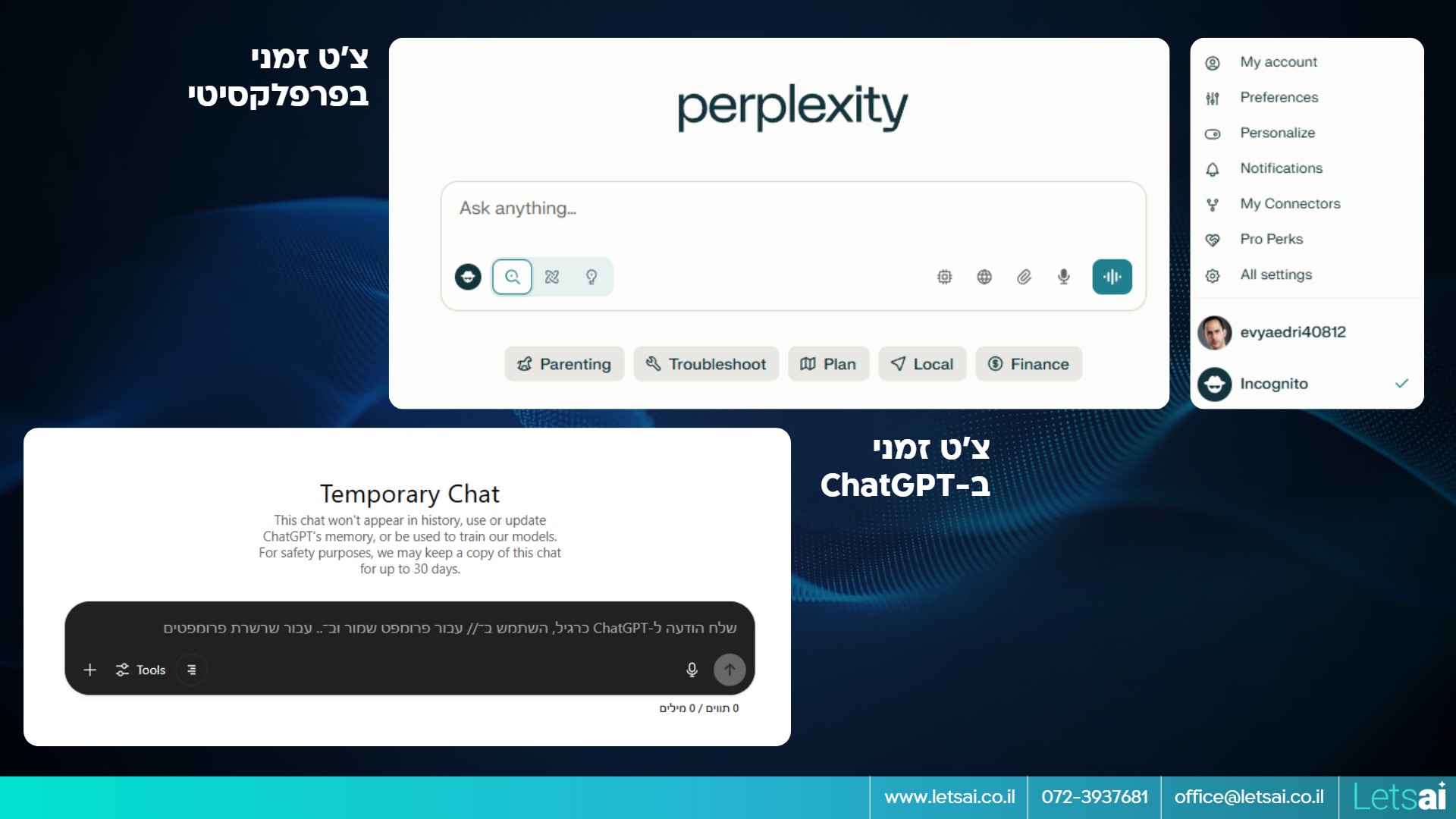

ב-ChatGPT (בגרסה החינמית ובגרסת Plus): כברירת מחדל, OpenAI משתמשת בשיחות שלכם כדי לאמן את המודלים שלה. חיוני להיכנס להגדרות (Settings), תחת Data Controls, ולכבות את האפשרות "Improve this model for everyone". בנוסף, תחת Personalization, ניתן לנהל את תכונת ה"זיכרון" (Memory) של המודל. לשימוש רגיש ונקודתי, ניתן להפעיל את מצב "Temporary Chat" – שיחה שאינה נשמרת בהיסטוריה ואינה משמשת לאימון המודל.

צ'ט זמני ב-Perplexity וב-ChatGPT.

עולם ה-AI לא נעצר בגבולות ממשק הצ'ט. הכלים המתקדמים מציעים אינטגרציות עמוקות עם מערכות ארגוניות, ומאפשרים גישה חכמה למידע בזמן אמת. אך ככל שהחיבורים מתרחבים, כך גובר גם הפוטנציאל לחשיפת מידע רגיש – ולעיתים קריטית. חיבור למערכות פנימיות דורש לא רק זהירות, אלא גם בקרה ברמת מדיניות. זה הרגע להבין מתי ואיך עושים את זה נכון, ובעיקר - מי מוסמך לאשר זאת.

השימוש ב-AI אינו מסתכם רק בהזנת טקסט. הכלים המתקדמים מאפשרים להתחבר למקורות מידע ארגוניים כמו Google Drive, מיילים, יומנים ומערכות ניהול משימות. לפני שאתם מחברים את ה-AI שלכם לנכסים הדיגיטליים של הארגון, חובה עליכם לקבל אישור מהגורמים המוסמכים.

עבור ארגונים בעלי דרישות אבטחה מקסימליות (כמו גופים ביטחוניים, משפטיים או פיננסיים), קיימים פתרונות On-Prem – מערכות סגורות המותקנות על שרתים פיזיים בתוך הארגון. פתרונות אלה מציעים את רמת ההגנה הגבוהה ביותר, מכיוון שהמידע אינו יוצא מגבולות הרשת הארגונית.

לפני כל אינטראקציה עם כלי בינה מלאכותית בסביבה הארגונית, עברו על הצ'קליסט הבא כדי לוודא שאתם פועלים בבטחה, בהתאם למדיניות, וממצים את הערך העסקי ללא חשיפת סיכונים מיותרים:

אימוץ והטמעת AI בעולמות האנטרפרייז מצריך אחריות – לא רק של מנהלי מערכות מידע, אנשי סייבר או הנהלה בכירה, אלא של כל משתמש בארגון. המעבר לשימוש יומיומי בכלים מבוססי בינה מלאכותית משנה את כללי המשחק: המידע כבר לא עובר רק דרך ערוצים מוגדרים ומפוקחים, אלא מוזן למערכות חיצוניות, מתחבר לפלטפורמות צד שלישי, ולעיתים נוגע באזורים רגישים במיוחד כמו קניין רוחני, מידע רפואי או פרטי לקוחות. כל טעות, אפילו בתום לב, עלולה להפוך לפרצת אבטחה או לאירוע רגולטורי חמור.

מהפכת ה-AI כבר כאן, והיא מציעה יתרונות אדירים. היכולת לחלץ תובנות במהירות, להאיץ תהליכים עסקיים, להפחית עומסים ולעזור בקבלת החלטות – כל אלה אינם תאורטיים אלא כבר מתרחשים בפועל. אך עם הכוח הזה מגיע גם הצורך בהבנה מעמיקה של ההשלכות. אתם, כמשתמשים, נמצאים בחזית, לעיתים אף לפני הארגון עצמו, ועדיין נחשבים כ-Early Adopters של הטכנולוגיה – קבוצה שמכתיבה את קצב האימוץ, אך גם נתונה לסיכונים שבהיעדר תקינה מספקת.

כדי ליהנות מפירות המהפכה וליצור ניצחונות מהירים, עליכם לפעול באחריות. זה אומר לא רק להכיר את הכלי שבו אתם משתמשים, אלא גם להבין את ההקשר הארגוני שבתוכו אתם פועלים. אל תסתפקו בהבנה טכנית – שאלו את השאלות הנכונות: מי שומר על המידע? האם נעשה בו שימוש לאימון מודלים? כיצד ניתן למחוק אותו? ודאו שאתם פועלים בהתאם למדיניות הפנימית של הארגון – לא על סמך הנחות, אלא על בסיס בירור אמיתי עם בעלי תפקידים רלוונטיים.

אל תפחדו מהסיכונים – פחד משתק, ואילו ניהול סיכונים חכם מאפשר לצמוח. אימוץ AI דורש אומץ, אך גם שקיפות, תיעוד, בקרה ובחירה בכלים המתאימים לצרכים שלכם. כשאתם ניגשים לעבודה עם כלים אלה מתוך מודעות וזהירות, אתם לא רק מגנים על עצמכם ועל המידע – אתם תורמים לשימוש מושכל ויציב בטכנולוגיה שצפויה ללוות אותנו לאורך השנים הבאות. רק כך תוכלו למנף את העוצמה של הבינה המלאכותית בבטחה, ביציבות ובאחריות.

בואו ללמוד איתנו בינה מלאכותית בקורס המקיף, העשיר והמבוקש בשוק. הצטרפו לאלפים הרבים שכבר עברו את הקורסים והסדנאות שלנו. פרטים והרשמה באתר.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

רוצים לקבל עדכונים על כל מה שחדש ומעניין בעולם ה-AI? הרשמו לניוזלטר שלנו!

תוצאות נוספות...