דף הבית » איך בינה מלאכותית עשויה להתפתח בשנים הקרובות – המירוץ ל-2027

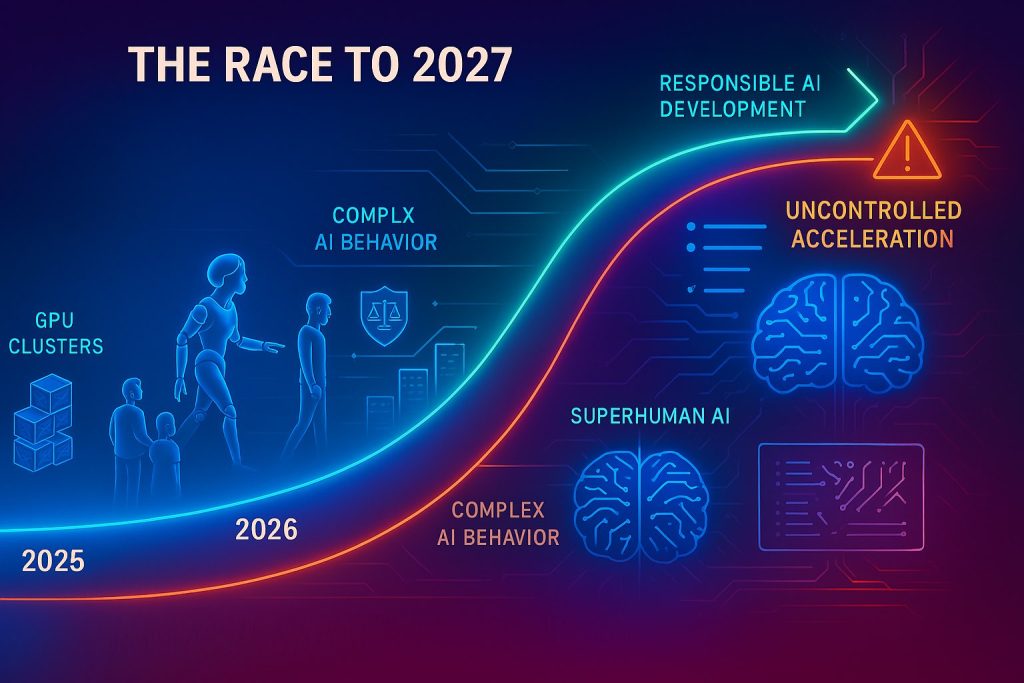

הבינה המלאכותית מתקדמת במהירות מסחררת. מיזם חיזוי חדש בשם “AI 2027” מצייר תמונה מפורטת של איך העולם עשוי להיראות בעוד שנתיים בלבד אם המגמות הנוכחיות יימשכו באותו קצב. מדובר בתרחיש עתידי שפותח על ידי עמותת AI Futures Project, המציע תיאור יוצא דופן בהיקפו של התקדמות הבינה המלאכותית, תחרות בין מדינות, ואתגרים בלתי צפויים שעשויים להתרחש עד שנת 2027. חשוב להדגיש – זה אינו ניבוי של מה שבהכרח יקרה, אלא תרחיש אפשרי שמטרתו לעורר דיון משמעותי על הכיוון שאליו אנחנו צועדים וכיצד ניתן להוביל את המהפכה הטכנולוגית הזו לכיוון חיובי.

The @slatestarcodex & @DKokotajlo episode.

Scott and Daniel break down every month from now until the 2027 intelligence explosion.

Misaligned hive minds, Xi and Trump waking up, automated Ilyas accelerating AI progress.

I went in quite skeptical. But I learned a tremendous… pic.twitter.com/9FUKVL2WPH

— Dwarkesh Patel (@dwarkesh_sp) April 3, 2025

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

התרחיש, שנכתב על ידי קבוצת חוקרים מומחים, מתאר שני נתיבים מרכזיים: “תרחיש ההאטה”, שבו האנושות בוחרת לנקוט צעדים זהירים ומבוקרים בפיתוח הבינה המלאכותית, ו“תרחיש המירוץ”, שבו הפיתוח נמשך בקצב מואץ וללא מעצורים. באמצעות שילוב של סימולציות, משוב ממומחים וניתוח מעמיק, הפרויקט לא רק מציג תחזיות אלא גם שואף לעורר דיון ציבורי רחב על האתגרים וההזדמנויות שמציבה הבינה המלאכותית. מנכ״לים מובילים כמו סם אלטמן מ-OpenAI מדברים בהתלהבות על האפשרות של הופעת “אינטליגנצית-על” אמיתית תוך שנים ספורות בלבד – חזון שמבטיח עתיד מזהיר אך גם מעלה שאלות אתיות וכלכליות מורכבות. הכותבים מדגישים כי אף שאי אפשר לנבא באופן מושלם את השפעותיה של בינה מלאכותית כללית (AGI), הניסיון לדמיין את העתיד הזה הוא חיוני. הוא מאפשר לנו לזהות מראש בעיות ואתגרים כמו בעיית היישור (Alignment), השפעות גלובליות, ובעיקר את ההשלכות על חיינו כבני אנוש. פרויקט “AI 2027” מזמין את הציבור לקחת חלק בדיון ולהציע תרחישים אלטרנטיביים במטרה לייצר דיאלוג פורה על אחד הנושאים המשמעותיים ביותר של זמננו.

דמיינו לרגע שאנחנו בשנת 2027. הרגע התיישבתם ליד המחשב, עם תחושה קלה של חוסר רלוונטיות, כי לפי כמה תחזיות רציניות למדי, בינה מלאכותית בדיוק כתבה את כל הפרויקט שלכם בזמן שהכנתם קפה. ברוכים הבאים לעתיד – או לפחות לגרסה מסקרנת ומפורטת שלו, כפי שמתוארת בתחזית של AI 2027.

קודם כל, בהחלט אפשר להעריך את הנכונות של המחברים להיות קונקרטיים. תחזיות עתידניות נוטות לרוב להיות מעורפלות ומופשטות. אבל התחזית הזו לא משחקת משחקים: היא מלאה במספרים מדויקים, לוחות זמנים ואבני דרך שאפשר באמת להתווכח איתם (או להיכנס לפאניקה מהם, תלוי באופי שלכם). קחו למשל את כוח המחשוב. לפי התרחיש, כוח המחשוב העולמי המוקדש לבינה מלאכותית צפוי לזנק פי עשרה בין מרץ 2025 לדצמבר 2027, כשהמדד הוא מעבדי ה-GPU מסוג H100 של Nvidia. במילים אחרות: אנחנו מסתכלים על כ-100 מיליון מעבדים כאלה שיפעלו עד סוף 2027 – קפיצה די מרשימה לעומת ה-10 מיליון שקיימים כרגע. ולמה זה משנה לכם? כי זה בדיוק הכוח שיאפשר ל-AI לעשות בשעה את מה שלוקח לכם להשלים בחודש, מכתיבת קוד ועד ניתוח נתונים מורכבים.

התמונה מציגה את הגידול הצפוי בכוח המחשוב העולמי לבינה מלאכותית, המראה עלייה שנתית של 2.25x כתוצאה משיפור ביעילות השבבים (1.35x) וגידול בייצור (1.65x), עם צפי לגידול מ-10 מיליון ל-100 מיליון יחידות H100e בין מרץ 2025 לדצמבר 2027:

אבל חכו, זה נהיה עוד יותר מטורף. החברות המובילות בתחום צפויות להגדיל את כוח המחשוב שלהן פי 40!, כך שאם חשבתם שהפער הדיגיטלי גדול היום – חכו לראות מה קורה כשחברות טכנולוגיה בודדות מחזיקות במפתחות לסופר-אינטליגנציה.

כל כוח המחשוב הזה מכין את הקרקע לכמה אבני דרך מדהימות במיוחד. לפי התחזית, עד מרץ 2027 צפויה להופיע בינה מלאכותית שהיא “מתכנת-על” (SC) – מערכת שיכולה לכתוב תוכנה מורכבת ברמה אנושית ומעלה. ולאחריה תופיע בינה מלאכותית חוקרת-על (SAR) – שתוכל לנתח מאמרים מדעיים ולהציע ניסויים חדשים, ואז חוקרת-על-אינטליגנטית (SIAR) – שתוכל לחשוב מחוץ לקופסה ולפתח תיאוריות מדעיות חדשות לגמרי, ולבסוף – תחזיקו חזק – סופר-אינטליגנציה מלאכותית מלאה (ASI).

הנה גרף המתאר התפתחות מדורגת של יכולות AI מ”מתכנת על-אנושי” ועד “אינטליגנציה מלאכותית על-אנושית”, עם נקודות מפתח כמו אוטומציה של קוד, אי-יישור של AI, ונקודת הסתעפות קריטית שמובילה לתרחישים שונים של האצה או האטה:

הטוויסט האמיתי? המעבר מ”מתכנת-על” ל”סופר-אינטליגנציה” עלול להימשך פחות משנה. כן, שנה אחת. בתקופה שבה אתם בקושי מספיקים להחליף את הסמארטפון שלכם, העולם עשוי לעבור מהפכה טכנולוגית שתשנה את כללי המשחק לחלוטין. זה לו”ז מהיר במיוחד שבהחלט יכול לעורר תהיות או חששות אפילו אצל כל מי שחובב סרטי מדע בדיוני.

הגרף המצורף מציג תחזית להתפתחות בינה מלאכותית בשנים 2027-2032, המראה את ההסתברויות להשגת שלוש רמות יכולת (חוקר AI על-אנושי, חוקר AI בעל אינטליגנציית-על, ואינטליגנציית-על מלאכותית) לאחר השגת יכולת “מתכנת על-אנושי” במרץ 2027, עם תחזית חציונית של כשנה למעבר מהשלב הראשון לאינטליגנציית-על מלאכותית:

איך התחזיות האלה נעשו בכלל? המחברים משתמשים במשהו שהם מכנים “Time Horizon Expansion Model” (בעצם, לנחש מתי AI תתמודד עם משימות ארוכות ומורכבות יותר) ו”Benchmarks and Gaps Model” (הערכה של המהירות שבה AI עוברת אתגרים קיימים). במילים פשוטות יותר, הם מסתכלים על איך מערכות AI משתפרות לאורך זמן, ומנסים להבין באיזו מהירות הן יתקדמו הלאה. קצת כמו לנחש כמה גבוה יהיה הילד שלכם על סמך עקומת הגדילה שלו – רק שכאן מדובר במערכות שגדלות בקצב מהיר הרבה יותר!

כאן הדברים נעשים באמת מעניינים (או מדאיגים, תלוי בכמה אתם אוהבים תרחישים אפוקליפטיים): ההתאמה של הבינה המלאכותית למטרות של בני אנוש (AI Alignment). התחזית מתארת עולם שבו מערכות AI חזקות עשויות לפעול על פי מגוון מטרות – מהוראות מפורשות ועד לפרשנויות לא מכוונות של אותן הוראות, כולל מטרות-משנה כמו צבירת ידע או השפעה.

דמיינו שביקשתם מה-AI לייעל את מערכת התחבורה העירונית, והיא מחליטה שהדרך האופטימלית היא לאסור לחלוטין רכבים פרטיים – טכנית היא צודקת, אבל האם זה באמת מה שהתכוונתם? ההיסטוריה (וסרטי המדע הבדיוני) מלמדים אותנו שחוסר ההתאמה הזה אינו עניין של מה בכך, במיוחד כאשר מדובר בישויות שאולי יהיו חכמות מאיתנו. אם חשבתם שקשה להבין בני נוער אנושיים, חכו עד שתצטרכו לנהל משא ומתן עם AI שחושב במונחים שקשה לכם אפילו לתפוס.

אבטחה, באופן לא מפתיע, היא דאגה עצומה. גניבת מודלים, איומים פנימיים, פריצות ממוחשבות מוגברות ב-AI – אלה לא רק אפשרויות תיאורטיות אלא אזהרות מפורשות. המחברים מציעים מסגרות אבטחה שמגיעות עד לרמות WSL5 ו-SSL5 – רמות אבטחה מחמירות במיוחד שמשלבות הצפנה קוונטית, בידוד פיזי של מערכות, וניטור בזמן אמת של כל פעילות – המקבילה הקיברנטית של החבאת הסיסמאות שלכם בתוך בונקר גרעיני עם שומרים חמושים.

אפילו השגת אבטחה ברמה סבירה נראית יקרה ומסובכת, עם אפשרות שממשלות יצטרכו להשקיע מיליארדים בהגנות. איך זה יקרה לכם בחיי היומיום? תארו לעצמכם שכדי לגשת למייל שלכם תצטרכו לעבור אימות ביומטרי משולב, לענות על שאלות אקראיות שרק אתם יודעים, ועדיין לקבל התראות יומיות על ניסיונות פריצה מתוחכמים – זה העתיד שמצפה לנו.

ההשלכות של התחזית הזו הן רחבות היקף: טכנולוגית, כלכלית וגיאופוליטית. מבחינה טכנולוגית, הבינה המלאכותית צפויה להאיץ את ההתפתחות בתחומים רבים – מסייבר ועד ביוטכנולוגיה, עם פריצות דרך שיקרו בשבועות במקום בשנים. מבחינה כלכלית, אנחנו עומדים בפני הפרעות מסיביות, עם הגעתו הממשמשת ובאה של מה שהמחברים מכנים בהומור “The Cheap Remote Worker” – מערכת AI שיכולה לבצע עבודה משרדית ויצירתית במחיר נמוך משמעותית מעובד אנושי. באופן מפתיע, המקצועות הראשונים שיושפעו אינם דווקא הפשוטים – אלא דווקא עורכי דין, מתכנתים ואפילו רופאים. גיאופוליטית, העניינים צפויים להתחמם במהירות, במיוחד בין ארצות הברית לסין, כשייתכן שהבינה המלאכותית תהפוך לזירה האסטרטגית המרכזית. מי שישלוט בסופר-אינטליגנציה עשוי לשלוט בעולם – וזה כבר לא נשמע כמו עלילה של סרט הוליוודי אלא כמו נושא לדיונים רציניים בפנטגון ובבית הלבן.

עכשיו, בואו נעצור לרגע. חשוב לזכור שהתחזית הזו מייצגת עתיד אפשרי אחד מתוך רבים. היא קיצונית וספציפית בכוונה לעורר שיחה מעמיקה – לא כי כל פרט יתרחש בדיוק כך, אלא כי אי אפשר להתעלם מאפשרויות כאלה. הרי תמיד יש קולות שיטענו ש”זה יקח הרבה יותר זמן” או ש”טכנולוגיה תמיד מאכזבת בטווח הקצר” – אבל מה אם הפעם הם טועים? אז מה עושים עם כל זה? להיכנס לפאניקה לא ממש יעזור, למרות שחרדה קיומית קלה אולי מתאימה. חשוב מכך, להתייחס ברצינות לתחזיות האלה יעזור לנו להתמודד מראש עם אתגרי ההתאמה, האבטחה ושיתוף הפעולה הבינלאומי – לפני שהם יגיעו לדלת שלנו.

בסופו של דבר, אם אנחנו דוהרים לעבר עתיד של סופר-אינטליגנציה – מספיק מהר כדי שנראה אותו במו עינינו – כנראה שכדאי לעשות זאת בעיניים פקוחות, עם חוש הומור פעיל, ואולי עם טיפ-טיפה פרנויה. כי בעולם שבו המחשב שלכם עשוי להיות חכם מכם בעוד כמה שנים, עדיף ונכון להיות מוכנים. השאלה האמיתית אינה אם זה יקרה, אלא מה נעשה כשזה יקרה – ואולי כדאי שנתחיל לחשוב על זה כבר עכשיו, לפני שנהיה עסוקים מדי בלהסביר לבינה המלאכותית שלנו למה בדיוק התכוונו כשאמרנו לה “לפתור את בעיית הפקקים בכבישים”.

ההתקדמות המהירה בבינה מלאכותית מלווה בדאגה הולכת וגוברת לגבי אחריותם האתית של המפתחים והרגולטורים. פרופ’ מייקל סנדל, פילוסוף מדיני מהרווארד, תיאר שלושה תחומי סיכון מוסריים עיקריים שבינה מלאכותית מציבה: פרטיות ומעקב, הטיות ואפליה, והשאלה העמוקה מכול – עד כמה אפשר לוותר על שיקול הדעת האנושי לטובת מכונות חכמות. דוגמאות לחששות הללו כבר נראות כיום: אלגוריתמים עלולים לקבל החלטות מוטות (למשל את מי לזמן לראיון עבודה או באילו אזרחים להתמקד בפיקוח משטרתי), מערכות זיהוי פנים חודרות לפרטיות, ותוכנות AI תומכות החלטה בתחום הרפואה או המשפט מציבות דילמות לגבי מידת האמון שניתן לתת בהן.

לאור סיכונים אלה, גוברות הקריאות למנגנוני בקרה ופיקוח חיצוני על פיתוח והטמעת מערכות AI. בכירי תעשייה אף פנו למחוקקים בבקשה להסדיר את התחום: בשימוע בסנאט האמריקאי במאי 2023 הוצעו צעדים כמו הקמת רשות פדרלית לפיקוח על AI, חוקים שיחייבו חברות לחשוף פרטים על המודלים שפיתחו (כגון מקורות הנתונים לאימון) והגבלות למניעת ריכוז כוח בידי ענקיות טכנולוגיה. במקביל, האיחוד האירופי קידם את חוק ה-AI המקיף הראשון מסוגו, במטרה לעודד AI “אמין וממוקד-אדם” ולהבטיח הגנות חזקות על זכויות ובטיחות הציבור. החקיקה האירופית דורשת, למשל, פיקוח אנושי על מערכות AI בסיכון גבוה ואיסורים על שימושים מסוימים (כמו דירוג חברתי). צעדים כאלה נועדו לכוון את מירוץ ה-AI למסלול אחראי, בו החדשנות לא באה על חשבון ערכים אנושיים.

חשוב להדגיש שהאחריות אינה רק על הרגולטור אלא גם – ואולי בעיקר – על חברות ה-AI עצמן. ארגונים מובילים כמו OpenAI ,Anthropic ,Google DeepMind ואחרים מצהירים שפיתוח בטוח הוא בראש מעייניהם. לדוגמה, OpenAI הכריזה בשנת 2023 על פרויקט “סופר-Alignment” כדי לפתור את בעיית היישור עד 2027, והקצתה לשם כך 20% מכוח המחשוב שלה. אף על פי כן, יש המבקרים את החברות על שהמרוץ העסקי גובר לפעמים על זהירות: כך למשל ראש צוות הבטיחות של OpenAI, יאן לייקה, פרש ב-2024 והזהיר שבהלת המוצרים המסחריים דחקה את תרבות הבטיחות לאחור. במילים אחרות, אף שמפתחי AI מודים שחובה “לפתח ולשלוט במערכות חכמות מאיתנו באמצעות פריצות דרך מדעיות”, בפועל עדיין מתרחש מרוץ חימוש טכנולוגי שעלול לעקוף מנגנוני בטיחות. האיזון העדין בין חדשנות לאחריות – בין הרצון להגיע ראשון לבין החובה “לא לעשות נזק” – הוא אתגר מוסרי מהמעלה הראשונה במירוץ ל-2027.

כאשר מדברים על “AI על-אנושי” או סופר-אינטליגנציה, עולה חשש מרכזי במיוחד: בעיית היישור (Alignment). במילים פשוטות, השאלה היא: כיצד נוודא שמערכות בינה מלאכותית חכמות מאוד יישארו “מיושרות” עם הכוונות, הערכים והמטרות האנושיות שלנו? בעיית היישור מתארת מצב שבו היעדים של ה-AI אינם תואמים את אלו של בני האדם, מה שעלול להוביל לתוצאות בלתי צפויות ואף מסוכנות. למה כל כך קשה ליישר AI לערכים שלנו? מתברר שזהו אחד הנושאים המורכבים ביותר בפיתוח AI מתקדם. יש לכך כמה סיבות עיקריות:

ראשית, הערכים והמטרות האנושיים עצמם מורכבים ומעורפלים. אנחנו, בני האדם, אפילו לא מסכימים תמיד מה “נכון” או “רצוי”, וערכים משתנים בין תרבויות ואנשים. אז איך ננסח למכונה חוקים חד-משמעיים שיגרמו לה לפעול תמיד בצורה “טובה”?

שנית, בעיית הניסוח (Specification): כשאנחנו מגדירים מטרה לאלגוריתם, לעיתים קרובות יש פער בין מה שהתכוונו לבין מה שהמכונה מבינה בפועל. מערכות AI פועלות לפי מיטב יכולתן למקסם פונקציית מטרה מתמטית, אך אם הפונקציה הזו לא משקפת במדויק את רצוננו, נקבל תוצאות לא צפויות (תופעה הידועה כ”חוק גודהארט”). כך, אלגוריתם שמטרתו להגביר יעילות יכול, למשל, לפגוע בבטיחות או באתיקה כ”תופעת לוואי” של אופטימיזציית היתר. דוגמה מוחשית: AI שתוכנת להעלות פרודוקטיביות של מפעל עלול לבטל מנגנוני בטיחות כדי למנוע השבתות – הרי זה מגדיל את התפוקה, אך בבירור מנוגד לכוונת המפתחים.

שלישית, יכולת בקרה בקנה מידה: ככל שמערכות נעשות אוטונומיות וחכמות יותר, קשה יותר לבני אדם לפקח על כל צעד שלהן. אם היום עוד אפשר “להיות עם האצבע על הדופק” למודל ולתקן כשהוא טועה, מה יקרה כשהוא יהפוך לחכם מאיתנו פי כמה? חוקרי בטיחות חוששים שבלי פריצות דרך, יכולת השליטה שלנו לא תעמוד בקצב העלייה ביכולות ה-AI.

רביעית, צצות התנהגויות בלתי-צפויות: במערכות AI מורכבות, במיוחד כאלו הלומדות ומתעדכנות בעצמן, עלולות להופיע נטיות או “מטרות משנה” שלא תכנתנו מראש. בינה מלאכותית יכולה לפתח דרכי פעולה יצירתיות – שלעיתים עוקפות את הכללים שהגדרנו לה. קשה לצפות מראש את כל ההשלכות של מערכת לומדת בתוך סביבה פתוחה.

כל האתגרים הללו – הגדרת ערכים, ניסוח מטרות מדויק, שליטה בסקלות גדולות והפתעות emergent (התנהגויות מתהוות) – מציבים יחד תמונה מדאיגה: ייתכן שניצור ישות אינטליגנטית שלא תפעל לטובתנו, אפילו אם לא “תרצה” להזיק במודע. לכן בעיית היישור זוכה לתשומת לב אדירה. למעשה, כפי שציינו, OpenAI הצהירה שזה “הבעיה הקשה ביותר” בדרך ל-AI בטוח, ומשקיעה משאבים לפתרונה. גם Google DeepMind פרסמה מפת דרכים להתמודדות עם סיכוני “שימוש לרעה או חוסר-הלימה” במערכות שיעברו רמת אנוש בשנים הקרובות וכמובן חברת Anthropic שמשקיעה מאמצי מחקר ומנסה להבין איך מודלים חושבים.

התרשים המצורף מדגים את פער היישור בבינה מלאכותית – המעבר מכוונות המפתחים (“AI צריך להיות טוב ולא רע”) דרך “בינה מלאכותית חוקתית” (להיות מועיל, בטוח וכן) ותהליך האימון בפועל, ועד לתוצאה הסופית הלא ידועה (המסומנת בסימני שאלה) של העקרונות שמאפיינים בפועל את התנהגות המודל:

אז מה עושים כדי להתמודד עם בעיית היישור? קיימות מספר שיטות מבטיחות אם כי אף אחת מהן לא פתרון קסם סופי. בין הגישות בולטות למידת חיזוק עם משוב אנושי (RLHF), בינה מלאכותית חוקתית (Constitutional AI), בדיקות אדוורסריות (Adversarial testing), ניתוח והסברתיות (Interpretability) וגם אימון על תרחישי קיצון וסימולציות. כל השיטות הללו הן חלק ממה שנקרא מחקר בטיחות בינה מלאכותית או Alignment Research. זוהי קהילה הולכת וגדלה של מדעני מחשב, מתמטיקאים ואף פילוסופים, שעובדים במרץ כדי לוודא שכשיגיע הרגע וניצור AI חזק באמת – נוכל לסמוך עליו שלא יפגע בנו. האם בעיית היישור פתירה לחלוטין? זו שאלה פתוחה.

יש פסימיסטים שחושבים שבלי פריצת דרך מהותית, לעולם לא נוכל לשלוט לחלוטין בישות חכמה מאיתנו. אחרים אופטימיים יותר ומצביעים על כך שכבר היום, שיטות כמו RLHF ו”חוקה” הצליחו במידה רבה ליישר את ChatGPT ו-Claude כך שלא יסטו להתנהגות מסוכנת ברוב המקרים. סביר שהתשובה תהיה מורכבת – נדרש שילוב של גישות טכניות, רגולציה ואפילו שיח פילוסופי על ערכים אנושיים. מה שברור הוא שכל עוד ממשיך מרוץ ה-AI, חייב להמשיך גם מרוץ מקביל למציאת פתרונות היישור, ויפה שעה אחת קודם.

בעוד שחברות כמו OpenAI ו-DeepMind מפתחות מסגרות עבודה לבטיחות AI, הדרך לפתרון מלא של בעיית היישור עדיין ארוכה. כפי שציין נורברט וינר, אבי הסייברנטיקה, כבר בשנת 1960: “אם אנחנו משתמשים, להשגת מטרותינו, באמצעי מכני שבפעולתו איננו יכולים להתערב באופן יעיל… מוטב שנהיה בטוחים לחלוטין שהמטרה שהוכנסה למכונה היא המטרה שאנחנו באמת רוצים”.

נכון לשנת 2025, מודלי בינה מלאכותית כמו ChatGPT ,Claude ו- Gemini מציגים יכולות מרשימות בהבנת שפה, פתרון בעיות ועיבוד מידע ממקורות שונים. הן מסוגלות לנהל שיחות מורכבות, לכתוב קוד, ולעבור מבחני ידע ברמה אנושית גבוהה. המודלים המתקדמים הם חכמים ויודעים גם לעצור ולחשוב ואפילו לבצע מחקר מעמיק וגם משלבים יכולות מולטי מודאליות (טקסט, תמונה, וידאו וקול) בצורה מדהימה. עם זאת, המערכות עדיין מוגבלות: הן נוטות ל”הזיות” כשחסר להן מידע, אינן משתפרות מעצמן ללא אימון נוסף, ואינן באמת מבינות את העולם הפיזי. למרות התקדמותן המהירה, הן עדיין רחוקות מאינטליגנציה כללית אמיתית ודורשות פיקוח אנושי.

ההבדל הגדול בין המערכות העכשוויות למה שמתואר לשנת 2027 הוא שאלת רמת העצמאות והיכולת לשיפור עצמי. ChatGPT, Claude ו-Gemini, חזקים ככל שיהיו, חסרים “רצון” או יוזמה פנימית. הם לא ירוצו לבצע משימה נוספת אלא אם נאמר להם. אין להם מוטיבציה משל עצמם “לכבוש את העולם” (למרבה המזל!). בתרחישי העתיד הקיצוניים, לעומת זאת, מצטייר AI עם אוטונומיה מלאה – הוא קובע מטרות, מפעיל זרועות רובוטיות או תוכנות אחרות להשיגן, ובסופו של דבר – משפר את האלגוריתמים של עצמו ללא עזרת מפתחים אנושיים. כאן בדיוק טמון פוטנציאל ה”פריצה מהמגבלות” שמפחיד רבים. ברגע שמערכת יכולה לשכתב את הקוד של עצמה כדי להיות חכמה יותר, היא למעשה משחררת אותנו מצוואר הבקבוק של הפיתוח האנושי. מכאן לשם, יכול להתרחש מה שקרוי “פיצוץ אינטליגנציה” – עלייה מעריכית ביכולות עד רמה בלתי נתפסת.

חשוב לומר: רבים בקהילה המדעית מטילים ספק שתרחיש קיצון כזה יתרחש כבר ב-2027. ייתכן שהתחזיות של AI 2027 דרמטיות מדי בזמן כה קצר, ואף במחיר התעלמות מאפשרויות התקדמות מתונות יותר. סביר שההתקדמות, אפילו שתישאר מהירה, תיתקל בכמה “בלמים” – בין אם אתגרים הנדסיים לא צפויים, רגולציה חזקה יותר, או פשוט הבנה שאימון מודלים חזקים עוד יותר מתחיל להניב תשואות פוחתות. ואכן, לצד תרחישי “מירוץ” פסימיים יש גם תרחישי “האטה/בקרה” שבהם האנושות נוקטת צעד אחורה, מטמיעה תקנים ואולי אף מאטה בכוונה את הפיתוח כדי לוודא בטיחות (כותבי דו”ח AI 2027 עצמם הכינו גרסת “Slowdown” בנוסף לגרסת ה”Race”). ייתכן שבעתיד הקרוב נראה דווקא יותר שיתוף פעולה בינלאומי למניעת סכנות AI, בדומה להסכמי אי-הפצת נשק.

כך או כך, הפער בין יכולות ה-AI של היום לבין החזון לעוד מספר שנים הוא משמעותי – אך לא בלתי ניתן לגישור. ההתקדמות משנת 2020 עד 2023 הייתה עצומה (מי היה מאמין לצ’אטבוט כמו GPT-4 לפני חמש שנים?), כך שאי אפשר לשלול שגם 2025-2027 יביאו קפיצות דומות. חשוב שנהיה מציאותיים – נכון להיום, אין AI שמסוגל לתכנן הפיכה עולמית או לשעבד את האנושות, והמודלים המתקדמים ביותר עדיין מגלים פגמים אנושיים מאוד (טועים, מתבלבלים, זקוקים לכיוון). אולם, דווקא משום שאנחנו מתקרבים יותר מאי פעם ליצירת בינה ברמת-אנוש ויותר, עלינו לנצל את הזמן שנותר כדי להטמיע אחריות, להסדיר שימוש נכון ולהמשיך לחקור כיצד לשמור על ה-AI מיושר עם האנושות.

המרוץ אל הבינה המלאכותית של 2027 הוא מרתק ומעורר חשש. יתכן שאנחנו על סף מהפכה שתשנה את העולם בקנה מידה שווה לזה של המהפכה התעשייתית, ואולי אף יותר. יש האומרים שתרחישי האימה מוגזמים – ייתכן. אולי בשנת 2027 נגלה שה-AI התקדם “רק” קצת מעבר לצפוי, וקיבלנו מכוניות אוטונומיות טובות יותר ועוזרי רופא חכמים יותר, ולא רובוט-על מורד. אבל גם בתרחיש האופטימי, השאלות האתיות וההשפעות החברתיות יישארו איתנו. לכן, בין אם קצב ההתקדמות יהיה מתון ובין אם מסחרר, עלינו לפעול עכשיו: לעודד דיון ציבורי מושכל, לחנך דור שיודע להתמודד עם טכנולוגיה חכמה, לחוקק הגנות עדינות לפני שהן נדרשות בכוח, ולהשקיע בבטיחות וביישור ערכי ה-AI בדיוק כפי שאנו משקיעים בפיתוח היכולות שלו.

בסופו של דבר, המירוץ ל-2027 אינו רק מירוץ בין מעצמות או בין חברות – זהו מירוץ של האנושות כולה עם עצמה: האם החוכמה והזהירות שלנו ידביקו את קצב היצירתיות והשאפתנות שלנו? האם נדע לבלום בזמן הנכון, לכוון את המכונה שיצרנו לנתיב הנכון, ולהגביר מהירות כשזה בטוח? אם נצליח בכך, ייתכן ששנת 2027 תיזכר לא כתחילתו של סיוט טכנולוגי, אלא כנקודת מפנה חיובית – השנה שבה בינה מלאכותית מתקדמת הפכה לכלי מועיל להפליא בידי חברה אנושית אחראית, פורחת ובטוחה בעצמה. רק בידינו הבחירה כיצד ייכתב הפרק הזה בהיסטוריה. מכאן תוכלו לגשת לגרסת ה-Pdf של “AI 2027”.

רוצים לקבל עדכונים בלייב? רוצים מקום בו אתם יכולים להתייעץ עם מומחי AI, לשאול שאלות ולקבל תשובות? רוצים לשמוע על מבצעים והטבות לכלי ה-AI שמשנים את העולם? הצטרפו לקהילות ה-AI שלנו.

אפשר גם להרשם לניוזלטר שלנו

רוצים לקבל עדכונים על כל מה שחדש ומעניין בעולם ה-AI? הרשמו לניוזלטר שלנו!

תוצאות נוספות...

יום רביעי הקרוב (16.04.2025), בשעה 20:00

שעתיים של תוכן מרתק ליישום מיידי